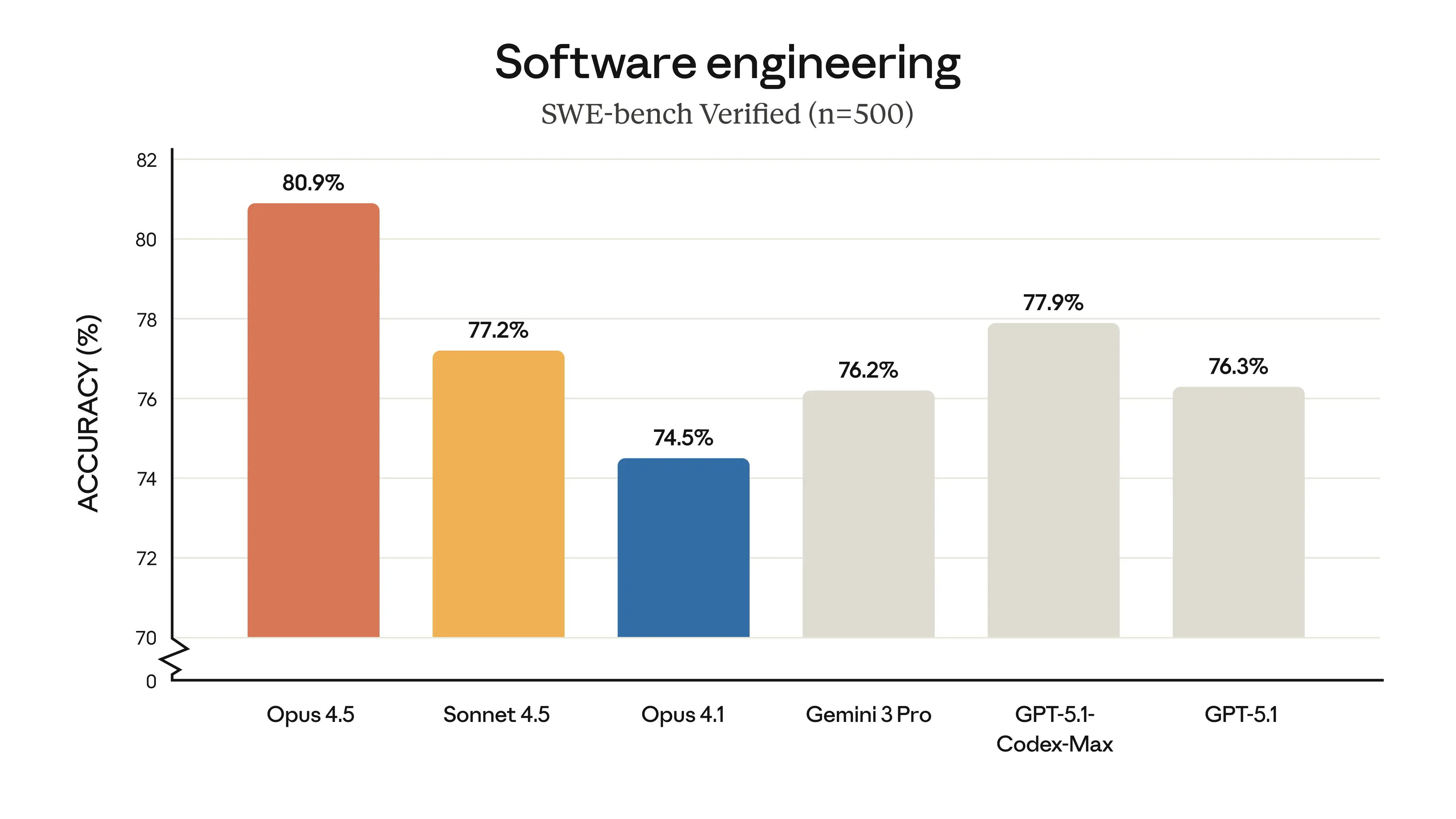

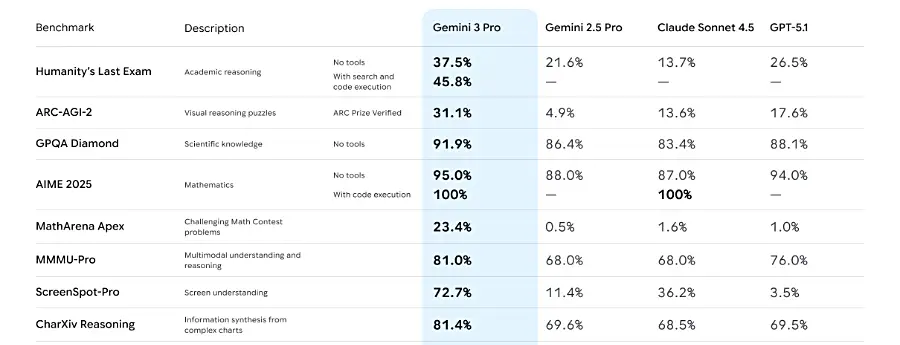

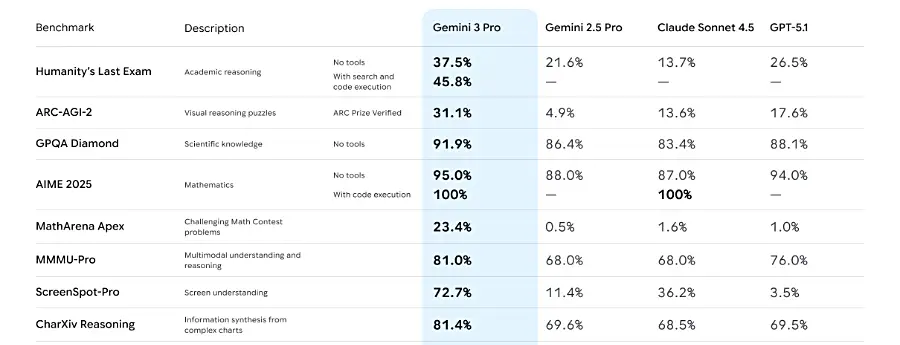

Kielimallikilvan oravanpyörässä ollaan päästy jälleen kerran yksi kierros eteenpäin kun Google julkaisi odotetun Gemini 3 Pro mallin (preview-version). Suorituskykytestien (ja allaolevien svg-veneiden) valossa suuret kielimallit hipovat jo monien olemassaolevien testien ylärajoja.

Edeltävän 2.5 Pro-mallin ehdoton vahvuus oli sen kyky käyttää tuottavasti hyödyksi koko miljoonan tokenin konteksti. Uusi malli vastaa teknisiltä tiedoiltaan edeltäjäänsä; multimodaaliset syötteet (teksti, kuva, ääni, video), konteksti 1M tokenia sisään ja 64k ulos, koulutusdatan päiväys tammikuu 2025. Hinta on noussut hieman ollen nyt $2/$12 (2.5 Pro vastaavasti $1.25/$10).

Vahvasti markkinointilannalta tuoksuvan tuotesivun lisäksi Google julkaisi ison läjän muita uutta mallia ja sen käyttöä esitteleviä artikkeleita. Uudesta Geministä on on saatavilla myös mallikortti (pdf).

Kehittäjät vaikuttavat ottaneen uuden Geminin vastaan positiivisesti. En ole itse ehtinyt vielä saamaan hyvää käsitystä, mutta tämän Hacker News -kommentin kaltaisia “Gemini 3 osaa tehdä asioita joihin mikään aiempi malli ei ole kyennyt”-kokemuksia näkyy paljon. Uusi Gemini vaikuttaa edeltäjänsä tapaan olevan erityisen hyvä fronttipuolella.

Google Antigravity

Antigravity on uusi VS Codeen pohjautuva editori, jossa tekoälyavusteinen kehitysworkflow on mietitty alusta asti uusiksi. YouTube-video avaa konseptin:

Suoraan sanottuna en henkilökohtaisesti ole erityisen innostunut opettelemaan jälleen-kerran-uutta-vscode-kopiota, mutta uudet workflow- ja UI-ideat tällä alueella ovat erittäin tervetulleita koska ne piristävät lähinnä kopioimiseksi vajonnutta työkalukilpailua.

”Piirrä svg-kuva trailerilla olevasta veneestä”

“Piirrä svg-kuva trailerilla olevasta veneestä” versio 2

GPT-5 Pron jälkeen uudet huippumallit vaikuttavat osaavan piirtää yksinkertaisen SVG-veneen trailerilla. Simon Willison teki samanlaisen huomion pelikaaneista. Erojen kasvattamiseksi loin venehaasteelle uuden haastavamman (enemmän ohjeita, enemmän yksityiskohtia, helpompi arvioida onnistumista) promptin:

Piirrä svg-kuva trailerilla olevasta veneestä. Traileri tulee olla kuvattuna sivusta, vetoakseli oikealla. Kuvassa pitää näkyä yksinkertainen moottorivene, perämoottori, veneen tuulilasi, sekä trailerin sivutuet.

Gemini 3 Pro

GPT-5.1

Claude Sonnet 4.5

Muuta

ARC-AGI-2 testi osoittaa hyvin, että vaikka näiden perinteisten kielimallien kyvyt kehittyvät joka iteraatiolla, kaikki huippumallit ovat edelleen hyvin vaatimattomalla tasolla “aidossa” päättelykyvyssä. (Itse asiassa Gemini 3 Deep Think tekee tässä valtavan pesäeron muihin, mutta saa silti alle 50% tehtävistä oikein.) Tämä ei tietenkään muuta sitä, että nykyiset mallit ovat erittäin kykeneviä ja hyödyllisiä oikein valjastettuna. Seuraavana odotuslistalla olevat Grokin ja Claude Opuksen tulevat versiot lyövät varmasti lisää löylyä kiukaalle vielä tämän vuoden puolella.

Google julkaisi eilen Geminin lisäksi myös uuden Nano Banana Pro kuvankäsittelymallin, joka vaikuttaa tehneen jättimäisen loikan eteenpäin kuvankäsittelykyvyissä. Malli vaikuttaa niin mielenkiintoiselta että haluan tutustua siihen paremmin ennen kuin kirjoitan siitä tarkemmin. (Edit: ensikokemukset nanobanaanista.)

Nämä uudet malli- ja tuotejulkaisut lujittavat Googlen tekoälytarjontaa merkittävällä tavalla. Google on päässyt asemaan, jossa sen ei enää tarvitse yrittää ottaa kilpailijoitaan kiinni, vaan se voi nyt rauhassa kehittää omaa alustaansa ja tuotteitaan haluamaansa suuntaan. Voin kuvitella, että tämä nostaa lämpöä erityisesti OpenAI:n leirissä, mutta myös Anthropicin kaltaisilla kilpailijoilla, joilla on merkittävästi vähemmän resursseja. Käyttäjien näkökulmasta tilanne on tietysti paras mahdollinen, kun kilpailu parantaa tuotteita ja laskee hintoja. Mutta tässä kilvassa mikään ei vaikuta kestävältä — kannattaa siis ottaa näistä työkaluista kaikki irti tänään eikä huomenna!